Saturday 13 December 2025 at 23:31

จากโพสต์ก่อนหน้าเมื่อหลายวันก่อนเรื่องที่ผมลองเริ่มย้ายมา subscribe AI เจ้าใหม่ก็คือ Z AI เพื่อลด cost ของตัวเอง แล้วเปลี่ยนจากการใช้ Opus 4.5 และ Sonnet 4.5 มาเป็น GLM 4.6 ก็มีรีวิวคร่าวๆ กันไปแล้วรอบนึงว่าเป็นยังไง

วันนี้จะมาบอกข้อเสียอีกข้อสำหรับคนที่ใช้ package Pro แบบผมที่เขาเพิ่ม feature ของการทำ Web Search และ Web Reader มาให้เป็น MCP Tool (ตามคู่มือ) เพื่อมาให้เพื่อชดเชย tool บางตัวที่ทำงานได้กับแค่สำหรับคน subscribe Claude เท่านั้น

พอดีช่วงนี้ผมก็กำลังเริ่ม setup Workflow จัดการชีวิตด้วย Claude Code(นี่ก็มาจากบทความก่อนหน้าอีก) แน่นอนว่าใช้ model glm-4.6 เพื่อความประหยัด แต่ปัญหามันเกิดตอนที่ผมพยายามสร้าง command “/daily-brief” เพื่อใช้มันให้ไปไล่อ่านข่าวตามเว็บที่ผมชอบเข้าไปเช็คแต่ละวันอยู่แล้ว จะได้ไม่ต้องเสียเวลานั่งอ่าน นั่งไถ

สิ่งที่ model มันทำก็เหมือนจะปกติก็คือ ไปเรียก web-search-prime mcp ขึ้นมาเพื่อใส่ leyword ที่ผมสนใจแล้วหาข่าวในช่วง 7 วัน แล้วค่อยใช้ web-reader เพื่ออ่านข่าวที่มัน search มาได้ ก่อนจะสรุปให้ผมได้เห็นว่าช่วงที่ผมหลับ มันมีข่าว AI อะไรใหม่ๆโผล่มาไหม(ดูเท่ๆ ดูคูล) 😎

แต่ผลลัพธ์มันแปลกๆ ผมเจอข่าวเจอข่าวเก่าๆที่เกี่ยวกับ AI ที่ผ่านมาแล้วหลายเดือน เลยเริ่มไม่ไว้ใจ function นี้ละ

[ 👮♂️ พิสูจน์หาคนผิด ]

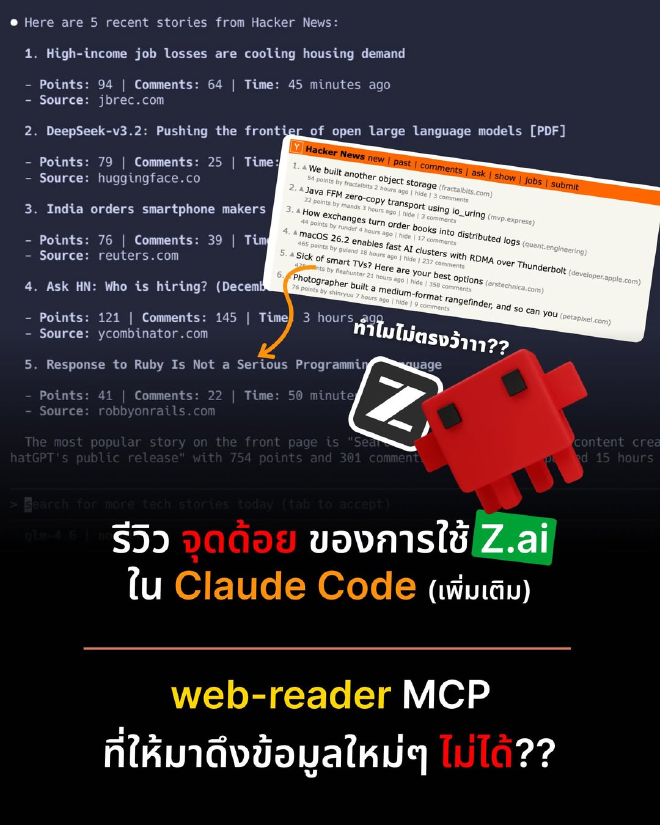

วันนี้เลยลองพิสูจน์เทียบเลยด้วย prompt ง่ายๆ

“””

fetch content from {URL หน้าแรก Hacker News} then pick 5 recent stories

“””

(Mark ไม่ชอบให้แปะ URL ใน post สงสัยกลัวคนอ่านหนีจาก Facebook 🤨)

แล้วเปิดเว็บเทียบไปด้วยเลยว่ามันได้ข่าวใหม่จริงๆ ไหม ซึ่งผลลัพธ์ก็คือ

⛔️ - GLM 4.6 กับ web-reader: ได้หน้าแรก Hacker News ใน version ที่เก่าไปประมาณ 2 สัปดาห์

✅ - Sonnet 4.5 กับ fetch: ได้ content ตรงกับหน้าแรกของ Hacker News เป๊ะเลย

✅ - GLM 4.6 กับ fetch: ได้ content ตรงกับหน้าแรกของ Hacker News เป๊ะเหมือนกัน (แต่เอา config map server ออก เพราะน้องไม่ยอมเรียกตอนแรก)

ชัดละ! เราประหยัด cost มาใช้ของเค้า เค้าก็ประหยัด cost ใส่เราด้วยการส่ง cache เก่าๆกลับมาสินะ 🥹

ที่เล่ามาจริงๆ เหมือนจะเป็นข้อเสีย แต่จริงๆมันแก้ได้ครับ ปัญหานี้แก้ได้ด้วยการถามก่อนเลย

ผมถามไปว่า “web-reader” mcp tool ตัวนี้มันมี parameter อะไรให้ set ได้บ้าง แล้วก็ได้คำตอบมาว่า

- timeout: 20 seconds

- no_cache: false « เจอตัว 🤯

- return_format: markdown

- retain_images: true

- no_gfm: false

- keep_img_data_url: false

- with_images_summary: false

- with_links_summary: false

ไอ้

no_cacheนี่มัน default เป็นfalseด้วย เลยไม่เคยงัดของใหม่มาให้เราได้อย่างทันใจ จริงๆ จะเก่าไปสัก 2-3 ชั่วโมง ก็ไม่ว่ากัน แต่พี่ล่อกันเป็นสัปดาห์เลย 😅 [ 🤔 แล้วสรุป พรศ ทำยังไง… ] ดังนั้นแล้วใครจะใช้ Z AI มาหาข้อมูลใหม่ๆ อย่าลืมย้ำไปใน prompt ให้ชัดว่า ใช้web-readerแล้วต้องno_cache: trueด้วย ไม่งั้นคุณอาจจะได้ข้อมูลเก่า ตกข่าวกันแบบงงๆ หรือแย่กว่านั้น ก็คือไปเผลออ่าน document version เก่าๆ ที่อาจจะทำให้ code เรามันไม่ work ก็ได้ แต่ใดๆก็ตาม tool ตัวนี้่ไม่สามารถไป อ่านพวก social network อย่าง X หรือ Facebook ได้นะครับ ต้องหาทางอื่นเอาเองเด้อ!!

เพิ่มเติมแบบฉีกอีกทีครับ ผมลองกับ OpenCode ที่เป็น Opensource อีกตัว โดยใช้ Z AI นี่แหละ ลองให้ทำงานกวาด hacker news มาสรุปแบบที่ไม่ลง mcp server ด้วย เอาดิบๆที่ OpenCode มีให้ใช้เลย สรุปผมว่า Z-AI ดูเหมือนจะไปได้ดีกับ OpenCode นะ ลองไปอ่านผลลัพธ์จาก prompt เดียวกันดู .